本文是作为Linuxshell编程的前置知识,但是因为其复杂性,我们额外开一篇文章来阐述

正则表达式

| 元字符 | 描述 | 示例 |

|---|---|---|

| \ | 转义符,将特殊字符进行转义,忽略其特殊意义 | a.b匹配a.b,但不能匹配ajb,.被转义为特殊意义 |

| ^ | 匹配行首,awk中,^则是匹配字符串的开始 | ^tux匹配以tux开头的行 |

| $ | 匹配行尾,awk中,$则是匹配字符串的结尾 | tux$匹配以tux结尾的行 |

| . | 匹配除换行符\n之外的任意单个字符 | ab.匹配abc或abd,不可匹配abcd或abde,只能匹配单字符 |

| [ ] | 匹配包含在[字符]之中的任意一个字符 | coo[kl]可以匹配cook或cool |

| [^] | 匹配[^字符]之外的任意一个字符 | 123[^45]不可以匹配1234或1235,1236、1237都可以 |

| [-] | 匹配[]中指定范围内的任意一个字符,要写成递增 | [0-9]可以匹配1、2或3等其中任意一个数字 |

| ? | 匹配之前的项1次或者0次 | colou?r可以匹配color或者colour,不能匹配colouur |

| + | 匹配之前的项1次或者多次 | sa-6+匹配sa-6、sa-666,不能匹配sa- |

| * | 匹配之前的项0次或者多次 | co*l匹配cl、col、cool、coool等 |

| () | 匹配表达式,创建一个用于匹配的子串 | ma(tri)?匹配max或maxtrix |

| {n} | 匹配之前的项n次,n是可以为0的正整数 | [0-9]{3}匹配任意一个三位数,可以扩展为[0-9][0-9][0-9] |

| {n,} | 之前的项至少需要匹配n次 | [0-9]{2,}匹配任意一个两位数或更多位数不支持{n,}{n,}{n,} |

| {n,m} | 指定之前的项至少匹配n次,最多匹配m次,n<=m | [0-9]{2,5}匹配从两位数到五位数之间的任意一个数字 |

| | | 交替匹配 | 两边的任意一项 |

POSIX字符类

[[:space:]],匹配多种类型的空白字符如空格\t、回车符\r、垂直制表符\v、换页符\f。[[:alnum:]]:匹配字母数字字符(a-z、A-Z、0-9)。[[:alpha:]]:匹配字母字符(a-z、A-Z)。[[:digit:]]:匹配数字字符(0-9)。[[:lower:]]:匹配小写字母字符(a-z)。[[:upper:]]:匹配大写字母字符(A-Z)。[[:punct:]]:匹配标点符号字符。[[:graph:]]:匹配可打印字符,不包括空格。[[:print:]]:匹配可打印字符,包括空格。[[:cntrl:]]:匹配控制字符。

三剑客:Grep、Awk、Sed

这么多文本工具,为什么要把这仨单独列出来呢?很简单,因为这三个是Linux文本处理领域的核心,三者配合使用,可以完成从搜索到分析再到编辑的完整文本处理流程,因此被形象地称为“文本处理三剑客”。

Grep

用法

[root@localhost ~]$ grep [选项] pattern [文件名]

选项:

-i:忽略大小写进行匹配。

-v:反向查找,只打印不匹配的行。

-n:显示匹配行的行号。

-r:递归查找子目录中的文件。

-l:只打印匹配的文件名。

-c:只打印匹配的行数。

-E: 拓展正则(默认只支持基础正则)

示例:

- 在文件file.txt中查找字符串hello,并打印匹配的行

grep hello file.txt

- 在文件夹dir中递归查找所欲文件中匹配正则表达式"pattern"的行,并打印匹配所在的文件名和行号:

grep -r -n pattern dir/

- 在标准输入中查找字符串world,并只打印匹配的行数

echo "hello world" | grep -c world

- 在当前目录中查找后缀有file字样的文件中包含test字符串的文件,并打印出该字符串的行。此时,可以使用如下命令:

grep test *file

- 反向查找,查看所有不带test的行

grep -v test test.txt

- 模式pattern

.:匹配任意单个字符(除了换行符)。比如,grep "h.t" file.txt 会匹配 "hat"、"hot"、"hit" 等。

*:匹配前面的字符出现零次或多次。例如,grep "go*" file.txt 会匹配 "go"、"goo"、"goooo" 等,也可以匹配空字符串(如果前面没有其他字符)。

^:表示行的开头。grep "^hello" file.txt 会匹配以 "hello" 开头的行。

$:表示行的结尾。grep "world$" file.txt 会匹配以 "world" 结尾的行。

[abc]:匹配方括号内的任意一个字符。例如,grep "[abc]" file.txt 会匹配包含 "a"、"b" 或 "c" 的行。

[a - z]:匹配指定范围内的任意字符。grep "[a - z]" file.txt 会匹配包含任意小写字母的行。

举例:列出子目录下所有以file开头.txt结尾的文件

ls */* | grep -E 'file.*\.txt$'

awk编程

awk概述

AWK 是一种处理文本文件的语言,是一个强大的文本分析工具。

printf格式化输出

[root@localhost ~]$ printf '输出类型输出格式' 输出内容

输出类型:

.: 表示精度,用于指定字符串的最大宽度。

%c: ASCII字符.显示相对应参数的第一个字符

%-ns: 输出字符串,减号“-”表示左对齐(默认右对齐),n是数字指代输出几个字符,几个参数就写几个%-ns

%-ni: 输出整数,n是数字指代输出几个数字

%s: 字符串。

%d: 十进制整数。

%x: 十六进制整数。

%o: 八进制整数。

%f: 浮点数。

%b: 解释转义字符的字符串。

%q: 将字符串安全地引用,以便可以作为 Shell 参数重新读取。

%%: 输出一个 % 字符。

%m.nf: 输出浮点数,m和n是数字,指代输出的整数位数和小数位数。如%8.2f代表共输出8位数,其中2位是小数,6位是整数。

输出格式:

\a: 输出警告声音

\b: 输出退格键,也就是Backspace键

\f: 清除屏幕

\n: 换行

\r: 回车,也就是Enter键

\t: 水平输出退格键,也就是Tab 键

\v: 垂直输出退格键,也就是Tab 键

为了演示printf命令,我们需要修改下刚刚cut命令使用的student.txt文件,文件内容如下:

[root@localhost ~]$ vi student.txt

ID Name php Linux MySQL Average

1 AAA 66 66 66 66

2 BBB 77 77 77 77

3 CCC 88 88 88 88

#printf格式输出文件

[root@localhost ~]$ printf '%s\t %s\t %s\t %s\t %s\t %s\t \n' $(cat student.txt)

#%s分别对应后面的参数,6列就写6个

ID Name php Linux MySQL Average

1 AAA 66 66 66 66

2 BBB 77 77 77 77

3 CCC 88 88 88 88

如果不想把成绩当成字符串输出,而是按照整型和浮点型输出,则要这样(8.2表示宽度为8字符,小数点保留两位)

[root@localhost ~]$ printf '%i\t %s\t %i\t %i\t %i\t %8.2f\t \n' \ $(cat student.txt | grep -v Name)

awk基本使用

[root@localhost ~]$ awk '条件1{动作1} 条件2{动作2}…' 文件名

条件(Pattern):

一般使用关系表达式作为条件。这些关系表达式非常多,例如:

x > 10 判断变量x是否大于10

x == y 判断变量x是否等于变量y

A ~ B 判断字符串A中是否包含能匹配B表达式的子字符串

A !~ B 判断字符串A中是否不包含能匹配B表达式的子字符串

动作(Action) :

格式化输出

流程控制语句

常用参数:

-F 指定输入时用到的字段分隔符

-v 自定义变量

-f 从脚本中读取awk命令

-m 对val值设置内在限制

我们这里先来学习awk基本用法,也就是只看看格式化输出动作是干什么的。

[root@localhost ~]$ awk '{printf $2 "\t" $6 "\n"}' student.txt

#输出第二列和第六列

比如刚刚截取df命令的结果时,cut命令已经力不从心了,我们来看看awk命令:

[root@localhost ~]$ df -h | awk '{print $1 "\t" $3}'

#截取df命令的第一列和第三列

awk的条件

| 条件的类型 | 条件 | 说明 |

|---|---|---|

| awk保留字 | BEGIN | 在awk程序一开始时,尚未读取任何数据之前执行。BEGIN后的动作只在程序开始时执行一次 |

| awk保留字 | END | 在awk程序处理完所有数据,即将结束时执行。END后的动作只在程序结束时执行一次 |

| 关系运算符 | > | 大于 |

| 关系运算符 | < | 小于 |

| 关系运算符 | >= | 大于等于 |

| 关系运算符 | <= | 小于等于 |

| 关系运算符 | == | 等于。用于判断两个值是否相等,如果是给变量赋值,请使用“”号 |

| 关系运算符 | != | 不等于 |

| 关系运算符 | A~B | 判断字符串A中是否包含能匹配B表达式的子字符串 |

| 关系运算符 | A!~B | 判断字符串A中是否不包含能匹配B表达式的子字符串 |

| 正则表达式 | /正则/ | 如果在"//"中可以写入字符,也可以支持正则表达式 |

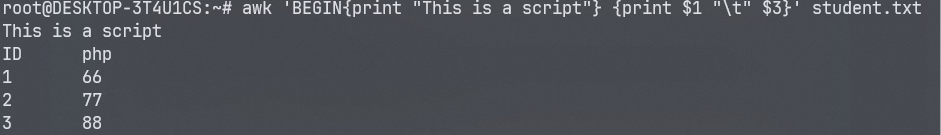

BEGIN

BEGIN是awk的保留字,是一种特殊的条件类型。BEGIN的执行时机是“在 awk程序一开始时,尚未读取任何数据之前执行”。一旦BEGIN后的动作执行一次,当awk开始从文件中读入数据,BEGIN的条件就不再成立,所以BEGIN定义的动作只能被执行一次。

例如:

[root@localhost ~]$ awk 'BEGIN{printf "This is a transcript \n" } {printf $2 "\t" $6 "\n"}' student.txt

#awk命令只要检测不到完整的单引号不会执行,所以这个命令的换行不用加入“|”,就是一行命令

#这里定义了两个动作

#第一个动作使用BEGIN条件,所以会在读入文件数据前打印“这是一张成绩单”(只会执行一次)

#第二个动作会打印文件的第二字段和第六字段

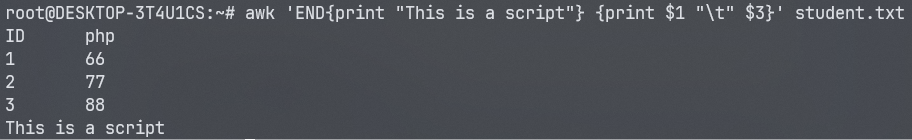

END

END也是awk保留字,不过刚好和BEGIN相反。END是在awk程序处理完所有数据,即将结束时执行。END后的动作只在程序结束时执行一次。例如:

[root@localhost ~]$ awk 'END{printf "The End \n"} {printf $2 "\t" $6 "\n"}' student.txt

#在输出结尾输入“The End”,这并不是文档本身的内容,而且只会执行一次

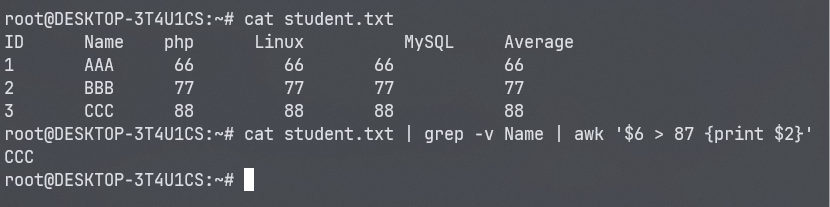

关系运算符

举几个例子看看关系运算符。假设我想看看平均成绩大于等于87分的学员是谁,就可以这样输入命令:

[root@localhost ~]$ cat student.txt | grep -v Name | awk '$6 >= 87 {printf $2 "\n"}'

#使用cat输出文件内容,用grep取反包含“Name”的行

#判断第六字段(平均成绩)大于等于87分的行,如果判断式成立,则打第六列(学员名$2)

加入了条件之后,只有条件成立动作才会执行,如果条件不满足,则动作则不运行。通过这个实验,大家可以发现,虽然awk是列提取命令,但是也要按行来读入的。这个命令的执行过程是这样的:

- 如果有BEGIN条件,则先执行BEGIN定义的动作。

- 如果没有BEGIN条件,则读入第一行,把第一行的数据依次赋予0、1、2等变量。其中0代表此行的整体数据,1代表第一字段,2代表第二字段。

- 依据条件类型判断动作是否执行。如果条件符合,则执行动作,否则读入下一行数据。如果没有条件,则每行都执行动作。

- 读入下一行数据,重复执行以上步骤。

再举个例子,如果我想看看Sc用户的平均成绩呢:

[root@localhost ~]$ awk '$2 ~ /AAA/ {printf $6 "\n"}' student.txt

#如果第二字段中输入包含有“Sc”字符,则打印第六字段数据

66

这里要注意在awk中,使用“//”包含的字符串,awk命令才会查找。也就是说字符串必须用“//”包含,awk命令才能正确识别。

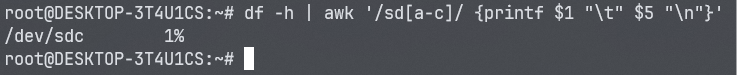

正则表达式

如果要想让awk 识别字符串,必须使用“//”包含,例如:

[root@localhost ~]$ awk '/Liming/ {print}'student.txt

#打印Liming的成绩

当使用df命令时,我不想查看光盘和临时分区

[root@localhost ~]$ df -h | awk '/sda[O-9]/ {printf $1 "\t" $5 "\n"}'

#查询包含有sda数字的行,并打印第一字段和第五字段

awk内置变量

| awk内置变量 | 作用 |

|---|---|

| $0 | 代表目前awk所读入的整行数据。我们已知awk是一行一行读入数据的,$0就代表当前读入行的整行数据。 |

| $n | 代表目前读入行的第n个字段。比如,1表示第1个字段(列),2表示第2个字段(列),如此类推 |

| NF | 当前行拥有的字段(列)总数。 |

| NR | 当前awk所处理的行,是总数据的第几行。 |

| FS | 用户定义分隔符。awk的默认分隔符是任何空格,如果想要使用其他分隔符(如“:”),就需要FS变量定义。(当然,-F参数嗯啊也行) |

| ARGC | 命令行参数个数。 |

| ARGV | 命令行参数数组。 |

| FNR | 当前文件中的当前记录数(对输入文件起始为1)。 |

| OFMT | 数值的输出格式(默认为%.6g)。 |

| OFS | 输出字段的分隔符(默认为空格)。 |

| ORS | 输出记录分隔符(默认为换行符)。 |

| RS | 输入记录分隔符(默认为换行符)。 |

awk常用统计案例

1、打印文件的第一列(域) :

awk '{print $1}' filename

2、打印文件的前两列(域) :

awk '{print $1,$2}' filename

3、打印完第一列,然后打印第二列 :

awk '{print $1 $2}' filename

4、打印文本文件的总行数 :

awk 'END{print NR}' filename

5、打印文本第一行 :

awk 'NR==1{print}' filename

6、打印文本第二行第一列 :

sed -n "2, 1p" filename | awk 'print $1'

1. 获取第一列

ps -aux | grep watchdog | awk '{print $1}'

2. 获取第一列,第二列,第三列

ps -aux | grep watchdog | awk '{print $1, $2, $3}'

3. 获取第一行的第一列,第二列,第三列

ps -aux | grep watchdog | awk 'NR==1{print $1, $2, $3}'

4. 获取行数NR

df -h | awk 'END{print NR}'

5. 获取列数NF(这里是获取最后一行的列数,注意每行的列数可能是不同的)

ps -aux | grep watchdog | awk 'END{print NF}'

6. 获取最后一列

ps -aux | grep watchdog | awk '{print $NF}'

7. 对文件进行操作

awk '{print $1}' fileName

8. 指定分隔符(这里以:分割)

ps -aux | grep watchdog |awk -F':' '{print $1}'

9. 超出范围不报错

ps -aux | grep watchdog | awk '{print $100}'

[root@localhost ~]$ cat /etc/passwd | grep "/bin/bash" | awk '{FS=":"} {printf $1 "\t" $3 "\n"}'

#查询可以登录的用户的用户名和UID

这里“:”分隔符生效了,可是第一行却没有起作用,原来我们忘记了“BEGIN”条件,那么再来试试;

[root@localhost ~]$ cat /etc/passwd | grep "/bin/bash" | awk 'BEGIN {FS=":"} {printf $1 "\t" $3 "\n"}'

[root@localhost ~]$ cat /etc/passwd | grep "/bin/bash" | awk 'BEGIN {FS=":"} {printf $1 "\t" $3 "\t 行号:” NR "\t 字段数:" NF "\n"}’

#解释下awk命令

#开始执行{分隔符是“:”}{输出第一字段和第三字段输出行号(NR值)字段数(NF值)}

root 0 行号:1 字段数:7

user1 501 行号:2 字段数:7

如果我只想看看sshd这个伪用户的相关信息,则可以这样使用:

[root@localhost ~]$ cat /etc/passwd | awk 'BEGIN {FS=":"} $1=="sshd" {printf $1 "\t" $3 "\t 行号:" NR "\t 字段数:" NF "\n"}'

#可以看到sshd 伪用户的UID是74,是/etc/passwd_文件的第28行,此行有7个字段

awk流程控制

我们再来利用下student.txt文件做个练习,后面的使用比较复杂,我们再看看这个文件的内容:

[root@localhost ~]$ cat student.txt

ID Name php Linux MySQL Average

1 AAA 66 66 66 66

2 BBB 77 77 77 77

3 CCC 88 88 88 88

我们先来看看该如何在awk中定义变量与调用变量的值。假设我想统计PHP成绩的总分,那么就应该这样:

[root@localhost ~]$ awk 'NR==2 {php1=$3}

NR==3 {php2=$3}

NR==4 {php3=$3;totle=phpl+php2+php3;print "totle php is " totle}' student.txt

#统计PHIP成绩的总分

我们解释下这个命令。“NR==2 {iphp1=3}” (条件是NR==2,动作是php1=3) 这句话是指如果输入数据是第二行(第一行是标题行),就把第二行的第三字段的值赋予变量“php1”。

“NR==3 {php2=3}" 这句话是指如果输入数据是第三行,就把第三行的第三字段的值赋予变量“php2”。“NR==4 {php3=3;totle=phpl+php2+php3;print “totle php is " totle}”(“NR==4”是条件,后面(中的都是动作)这句话是指如果输入数据是第四行﹐就把第四行的第三字段的值赋予变量"php3”;然后定义变量totle的值是“php1+php2+php3”;然后输出“totle php is”关键字,后面加变量totle的值。

在awk编程中,因为命令语句非常长,在输入格式时需要注意以下内容:

多个条件 {动作} 可以用空格分割,也可以用回车分割。

在一个动作中,如果需要执行多个命令,需要用 “;” 分割,或用回车分割。

在awk中,变量的赋值与调用都不需要加入“$”符。

条件中判断两个值是否相同,请使用 “==”,以便和变量赋值进行区分。

在看看该如何实现流程控制,假设如果Linux成绩大于90,就是一个好男人(学PHP的表示压力很大!) :

[root@localhost ~]$ awk '{if (NR>=2) {if ($4>60) printf $2 "is a good man!\n"}}' student.txt

#程序中有两个if判断,第一个判断行号大于2,第二个判断Linux成绩大于90分

Liming is a good man !

Sc is a good man !

其实再awk中if判断语句,完全可以利用awk自带的条件来取代,刚刚的脚本可以改写成这样:

[root@localhost ~]$ awk ’NR>=2 {test=$4}

test>90 {printf $2 "is a good man! \n"}’ student.txt

#先判断行号如果大于2,就把第四字段赋予变量test

#在判断如果test的值大于90分,就打印好男人

Liming is a good man!

Sc is a good man!

awk函数

awk编程也允许在编程时使用函数,我们讲讲awk的自定义函数。awk函数的定义方法如下:

function 函数名(参数列表){

函数体

}

我们定义一个简单的函数,使用函数来打印student.txt的学员姓名和平均成绩,应该这样来写函数:

[root@localhost ~]$ awk 'function test(a,b) { printf a "\t" b "\n"}

#定义函数test,包含两个参数,函数体的内容是输出这两个参数的值

{ test($2,$6) } ' student.txt

#调用函数test,并向两个参数传递值。

Name Average

AAA 87.66

BBB 85.66

CCC 91.66

awk中调用脚本

对于小的单行程序来说,将脚本作为命令行自变量传递给awk是非常简单的,而对于多行程序就比较难处理。当程序是多行的时候,使用外部脚本是很适合的。首先在外部文件中写好脚本,然后可以使用awk的-f选项,使其读入脚本并且执行。

例如,我们可以先编写一个awk脚本:

[root@localhost ~]$ vi pass.awk

BEGIN {FS=":"}

{ print $1 "\t" $3}

然后可以使用“-f”选项来调用这个脚本:

[root@localhost ~]$ awk -f pass.awk /etc/passwd

rooto

bin1

daemon2

…省略部分输出…

sed文本操作

sed主要是用来将数据进行选取、替换、删除、新增的命令。

语法:

[root@localhost ~]$ sed [选项] ‘[动作]’ 文件名

选项:

-n: 一般sed命令会把所有数据都输出到屏幕,如果加入此选择,则只会把经过sed命令处理的行输出到屏幕。

-e: 允许对输入数据应用多条sed命令编辑。

-f: 脚本文件名: 从sed脚本中读入sed操作。和awk命令的-f非常类似。

-r: 在sed中支持扩展正则表达式。

-i: 用sed的修改结果直接修改读取数据的文件,而不是由屏幕输出

动作:

num a \: 追加,在当前行后添加一行或多行。添加多行时,除最后一行外,每行末尾需要用“\”代表数据未完结。num表示第几行

c \: 行替换,用c后面的字符串替换原数据行,替换多行时,除最后一行外,每行末尾需用“”代表数据未完结。

num i \: 插入,在当期行前插入一行或多行。插入多行时,除最后一行外,每行末尾需要用“”代表数据未完结。num表示第几行

d ; 删除,删除指定的行。

p : 打印,输出指定的行。

s : 字串替换,用一个字符串替换另外一个字符串。格式为“行范围s/"旧字串/新字串/g"(和vim中的替换格式类似)。

对sed命令大家要注意,sed所做的修改并不会直接改变文件的内容(如果是用管道符接收的命令的输出,这种情况连文件都没有),而是把修改结果只显示到屏幕上,除非使用“-i”选项才会直接修改文件。

提取行数据

我们举几个例子来看看sed命令到底是干嘛的。假设我想查看下student.txt的第二行,那么就可以利用“p”动作了:

[root@localhost ~]$ sed '2p' student.txt

ID Name php Linux MySQL Average

1 AAA 66 66 66 66

2 BBB 77 77 77 77

3 CCC 88 88 88 88

指定输出某行,使用-n选项

[root@localhost ~]$ sed -n '2p' student.txt

1 AAA 66 66 66 66

删除行数据

[root@localhost ~]$ sed '2,4d' student.txt

#删除第二行到第四行数据

通过删除行数据,我们可以转换思路,比如我想看第二行到文件结尾的数据,不看第一行,那就只用删掉第一行就好了(或者'NR > 1' file.txt,或者tail -n +2 file.txt)

sed '1d' file.txt

追加插入行数据

[root@localhost ~]$ sed '2a hello' student.txt

#在第二行后加入 hello

“a”会在指定行后面追加入数据,如果想要在指定行前面插入数据,则需要使用“i”动作:

[root@localhost ~]$ sed '2i hello world' student.txt

#在第二行前插入两行数据

如果是想追加或插入多行数据,除最后一行外,每行的末尾都要加入“\”代表数据未完结。

再来看看“-n”选项的作用:

[root@localhost ~]$ sed -n '2i hello world' student.txt

#只查看sed命令操作的数据

在sed中只能指定行范围,所以很遗憾我在他们两个的中间,不能只把他们两个注释掉,那么我们可以这样:

[root@localhost ~]$ sed -e 's/AAA//g ; s/BBB//g' student.txt

#同时把“Liming”和“Tg”替换为空

替换行数据

“-n”只查看sed命令操作的数据,而不是查看所有数据。

再来看看如何实现行数据替换,假设AAA的成绩太好了,我实在是不想看到他的成绩刺激我,那就可以使用"c"动作:

[root@localhost ~]$ cat student.txt | sed '2c No such person'

字符串替换

“c”动作是进行整行替换的,如果仅仅想替换行中的部分数据,就要使用“s”动作了。g 使得 sed 对文件中所有符合的字符串都被替换, 修改后内容会到标准输出,不会修改原文件。

[root@localhost ~]$ sed 's/旧字串/新字串/g' 文件名

[root@localhost ~]$ sed '行范围s/旧字串/新字串/g' 文件名

替换的格式和vim非常类似,假设我觉得我自己的PHP成绩太低了,想作弊给他改高点,就可以这样来做:

[root@localhost ~]$ sed '3s/74/99/g' student.txt

#在第三行中,把74换成99

这样看起来就比较爽了吧。如果我想把AAA老师的成绩注释掉,让他不再生效。可以这样做:

[root@localhost ~]$ sed '2s/^/#/g' student.txt

#这里使用正则表达式,“^”代表行首

在sed中只能指定行范围,所以很遗憾我在他们两个的中间,不能只把他们两个注释掉,那么我们可以这样:

[root@localhost ~]$ sed -e 's/AAA//g ; s/BBB//g' student.txt

#同时把“Liming”和“Tg”替换为空

“-e”选项可以同时执行多个sed动作,当然如果只是执行一个动作也可以使用“-e”选项,但是这时没有什么意义。还要注意,多个动作之间要用“;”号分割。

高级用法

学哭了,有好多高级功能没学明白,我列在下面

- 多模式空间操作

- 分支和循环

- 多行处理

- sed脚本运行和调试

这里写几个例子算了吧(感觉学了也忘,到时候问ai的说)

常用示例:

- 删除文件中的连续空行

sed ':a;N;$!ba;s/\n\n\n*/\n/g' file.txt

- 反转文件内容

sed -n '1!H;$!d;g;p' file.txt

- 删除文件开头/结尾的特定字符

sed -i 's/^hello//' file.txt

sed -i 's/^hello[[:space:]]*//' file.txt

# 如果不需要保留空格

sed -i 's/hello$//' file.txt

sed -i 's/[[:space:]]*hello$//' file.txt

# 如果不需要保留空格

sed -i '2,10s/^hello//' file.txt

# 同样可以指定行数

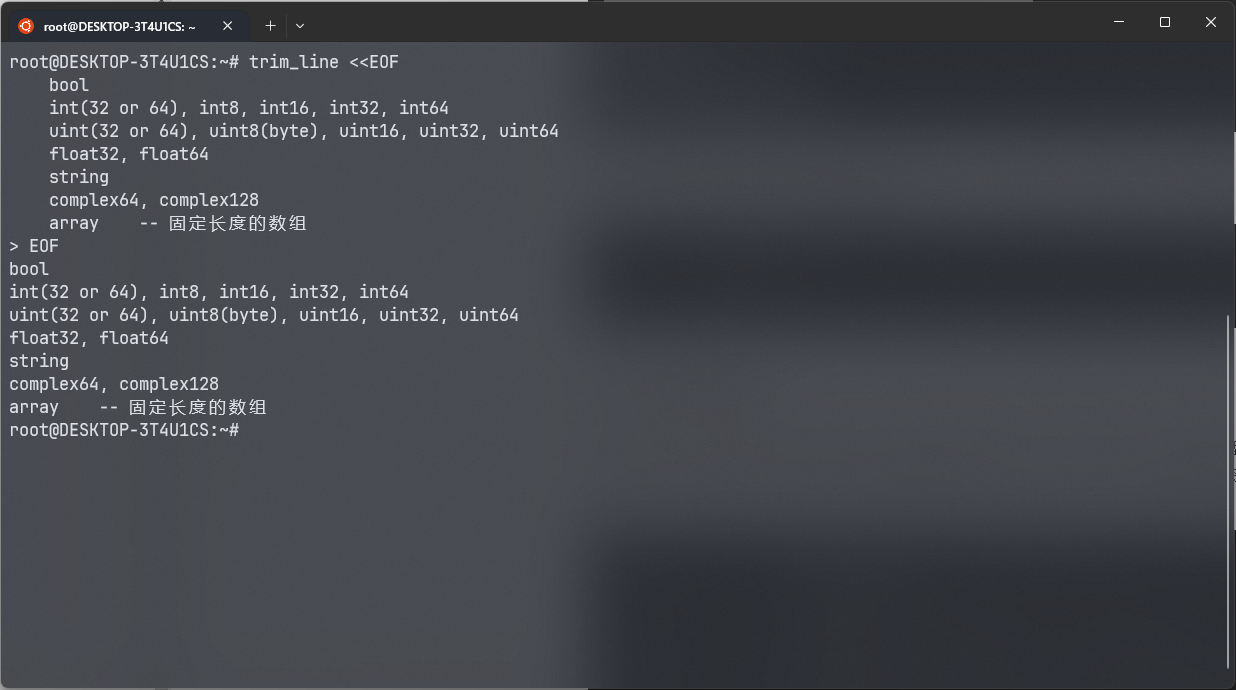

学以致用啊兄弟们,设置个alias,标准输入或者直接对着文件去头尾空格,用过的都说好

alias trim_lines='while IFS= read -r line; do trimmed_line=$(echo "$line" | sed "s/^[[:space:]]*//;s/[[:space:]]*$//"); echo "$trimmed_line"; done'

或者

alias trim_line='sed "s/^[[:space:]]*//;s/[[:space:]]*$//"'

其他简单工具

cut:列提取

[root@localhost ~]$ cut [选项] 文件名

选项:

-f 列号: 提取第几列

-d 分隔符: 按照指定分隔符分割列

-n 取消分割多字节字符

-c 字符范围: 不依赖分隔符来区分列,而是通过字符范围(行首为0)来进行字段提取。“n-”表示从第n个字符到行尾;“n-m”从第n个字符到第m个字符;“一m”表示从第1个字符到第m个字符。

--complement 补足被选择的字节、字符或字段

--out-delimiter 指定输出内容是的字段分割符

cut命令的默认分隔符是制表符,也就是“tab”键,不过对空格符可是支持的不怎么好啊。我们先建立一个测试文件

[root@localhost ~]$ vi student.txt

id name gender mark

1 liming m 86

2 sc m 67

3 tg n 90

[root@localhost ~]$ cut -f 2 student.txt

#提取第二列内容

那如果想要提取多列呢?只要列号直接用“,”分开,命令如下:

[root@localhost ~]$ cut -f 2,3 student.txt

cut可以按照字符进行提取,需要注意“8-”代表的是提取所有行的第八个字符开始到行尾,而“10-20”代表提取所有行的第十个字符到第二十个字符,而“-8”代表提取所有行从行首到第八个字符:

[root@localhost ~]$ cut -c 8- student.txt

#提取第八个字符开始到行尾,好像很乱啊,那是因为每行的字符个数不相等啊

[root@localhost ~]$ cut -d ":" -f 1,3 /etc/passwd

#以“:”作为分隔符,提取/etc/passwd_文件的第一列和第三列

如果我想用cut命令截取df命令的第一列和第三列,就会出现这样的情况:

[root@localhost~]$ df -h | cut -d " " -f 1,3

Filesystem

/dev/sda2

tmpfs

/dev/sda1

tr:字符级别转换处理

(translate)是 Linux 中一个非常强大的文本处理工具,主要用于字符级别的转换、删除和压缩重复字符。它的功能相对简单,但非常高效,尤其适合处理简单的文本转换任务。

用法:

[root@localhost~]$ tr [选项] <SET1> <SET2>

选项:

-d:删除 SET1 中指定的字符。

-s:压缩 SET1 中连续重复的字符为一个字符。

-c:取反,操作 SET1 之外的字符。

-t:截断 SET2,使其长度与 SET1 相同(仅在转换时使用)。

参数说明:

SET1:指定要操作的字符集。

SET2:指定目标字符集(仅在进行字符替换时使用)。

示例:

- 字符替换(比如这里替换大小写)

echo "Hello, world! 123" | tr 'a-z' 'A-Z'

- 删除字符(这里删除所有的空格)

echo "Hello, world!" | tr -d ' '

- 压缩重复字符(这里把多个空格压缩为一个)

echo "Hello, world!" | tr -s ' '

- 取反操作(这里删除所有非字母字符,包括空格换行)

echo "Hello, world! 123" | tr -cd 'a-zA-Z'

sort:字符排序

[root@localhost~]$ sort [选项] 文件名

选项:

-f: 忽略大小写

-b: 忽略每行前面的空白部分

-n: 以数值型进行排序,默认使用字符串型排序

-r: 反向排序

-u: 删除重复行。就是经过排序的uniq命令

-t: 指定分隔符,默认是分隔符是制表符

-k n[,m]: ―按照指定的字段范围排序。从第n字段开始,m字段结束(默认到行尾)

案例:

sort命令默认是用每行开头的第一个字符进来排序的,比如:

[root@localhost~]$ sort /etc/passwd

#排序用户信息文件

如果想要反向排序,请使用“-r”选项:

[root@localhost~]$ sort -r/etc/passwd

#反向排序

如果想要指定排序的字段,需要使用“-t”选项指定分隔符,并使用“-k”选项指定字段号。加入我想要按照UID字段排序/etc/passwd文件:

[root@localhost~]$ sort -t ":" -k 3,3 /etc/passwd

#指定分隔符是“:”,用第三字段开头,第三字段结尾排序,就是只用第三字段排序

因为sort默认是按照字符排序,前面用户的UID的第一个字符都是1,所以这么排序。要想按照数字排序,请使用“-n”选项:

[root@localhost~]$ sort -n -t ":" -k 3,3 /etc/passwd

当然“-k”选项可以直接使用“-k 3”,代表从第三字段到行尾都排序(第一个字符先排序,如果一致,第二个字符再排序,知道行尾)。

uniq:文件去重

[root@localhost~]$ uniq [选项] 文件名

选项:

-i:忽略大小写

join:合并文件

[root@localhost~]$ john [选项] 文件名

选项:

-1:指定第一个文件的合并字段。

-2:指定第二个文件的合并字段。

-j FIELD: 相等于'-1 FIELD -2 FIELD'

-i: 忽略大小写

-o:指定输出格式。

示例:

假设文件 file1.txt 和 file2.txt 内容如下:

file1.txt:

apple 10

banana 20

cherry 30

file2.txt:

apple red

banana yellow

cherry green

按照第一列合并文件:

join -1 1 -2 1 file1.txt file2.txt

输出:

apple 10 red

banana 20 yellow

cherry 30 green

paste:粘贴合并

[root@localhost~]$ paste [选项] 文件名

选项:

-d:指定字段分隔符。默认情况下,paste 使用制表符作为分隔符

-s:将每个文件的内容合并成一行输出,而不是按列合并(先横过来,再竖着粘)

假设文件file1.txt和 file2.txt内容如下:

file1.txt:

apple

banana

cherry

file2.txt:

red

yellow

green

合并两个文件

apple red

banana yellow

cherry green

wc:统计字数

[root@localhost~]$ wc [选项] 文件名

选项:

-l:只统计行数

-w:只统计单词数

-m:只统计字符数

bash参数拓展

1. 去除字符串前缀

${parameter#pattern}:从变量的开头删除最短匹配的模式(删到第一个匹配)。${parameter##pattern}:从变量的开头删除最长匹配的模式(删到最后一个匹配)。

示例:

filename="linux.bash.txt"

echo ${filename#*.} # 输出:bash.txt

echo ${filename##*.} # 输出:txt

2. 去除字符串后缀

${parameter%pattern}:从变量的结尾删除最短匹配的模式(删最后一个)。${parameter%%pattern}:从变量的结尾删除最长匹配的模式(删到第一个)。

示例:

filename="linux.bash.txt"

echo ${filename%.*} # 输出:linux.bash

echo ${filename%%.*} # 输出:linux

替换字符串中的内容

${parameter/pattern/string}:替换变量中第一个匹配的模式。${parameter//pattern/string}:替换变量中所有匹配的模式。${parameter/#pattern/string}:替换变量开头的匹配模式。${parameter/%pattern/string}:替换变量结尾的匹配模式。

示例:

string="hello world"

echo ${string/world/universe} # 输出:hello universe

echo ${string//world/universe} # 输出:hello universe

echo ${string/#hello/goodbye} # 输出:goodbye world

echo ${string/%world/universe} # 输出:hello universe

4. 获取字符串长度

${#parameter}:获取变量值的长度。

示例:

string="hello world"

echo ${#string} # 输出:11

5. 截取子字符串

${parameter:offset}:从变量的指定位置开始提取子字符串。${parameter:offset:length}:从变量的指定位置开始提取指定长度的子字符串。

示例:

string="hello world"

echo ${string:6} # 输出:world

echo ${string:6:5} # 输出:world

6. 条件替换

${parameter:-word}:如果变量未定义或为空,则使用word作为默认值。${parameter:=word}:如果变量未定义或为空,则将变量赋值为word。${parameter:+word}:如果变量已定义且不为空,则返回word,否则返回空字符串。${parameter:?word}:如果变量未定义或为空,则输出word到标准错误并退出脚本。

示例:

var=${undefined:-"default"}

echo $var # 输出:default

var=${undefined:="default"}

echo $var # 输出:default

var="value"

echo ${var:+"exists"} # 输出:exists

var=${undefined:?"error message"}

# 如果变量未定义,将输出错误信息并退出脚本

评论